La IA no descansa, ni los fines de semana. Mientras tú estabas pensando en desconectar del trabajo y recuperar vida social, Meta decidía que era un buen momento para agitar el tablero de ajedrez de la inteligencia artificial. ¿Una filtración? ¿Un teaser? Nada de eso. Un lanzamiento completo, con cuatro nuevos modelos bajo el nombre de Llama 4, su nueva generación de inteligencia artificial open source que promete ver y entender el mundo mejor que nunca.

Porque sí, mientras otros siguen rascando la superficie de lo que una IA puede hacer, en Menlo Park han decidido que ya va siendo hora de que una IA entienda imágenes, vídeos y texto al mismo tiempo con una fluidez que roza lo escalofriante. Y lo hacen con todo el descaro del mundo: presentando a sus criaturas no como juguetes de laboratorio, sino como armas listas para la batalla. Llama 4 llega con la ambición de reventar benchmarks, infiltrarse en tus apps favoritas y mirar de tú a tú (o incluso por encima) a los modelos más punteros de OpenAI, Google o Anthropic.

Una bestia con cerebro compartimentado: así funciona Llama 4 por dentro

Llama 4 no solo impresiona por su versatilidad, sino también por sus cifras. Y es que Meta no se ha quedado en retoques cosméticos: lo que tenemos aquí es una arquitectura completamente nueva, pensada para sacar más rendimiento con menos gasto.

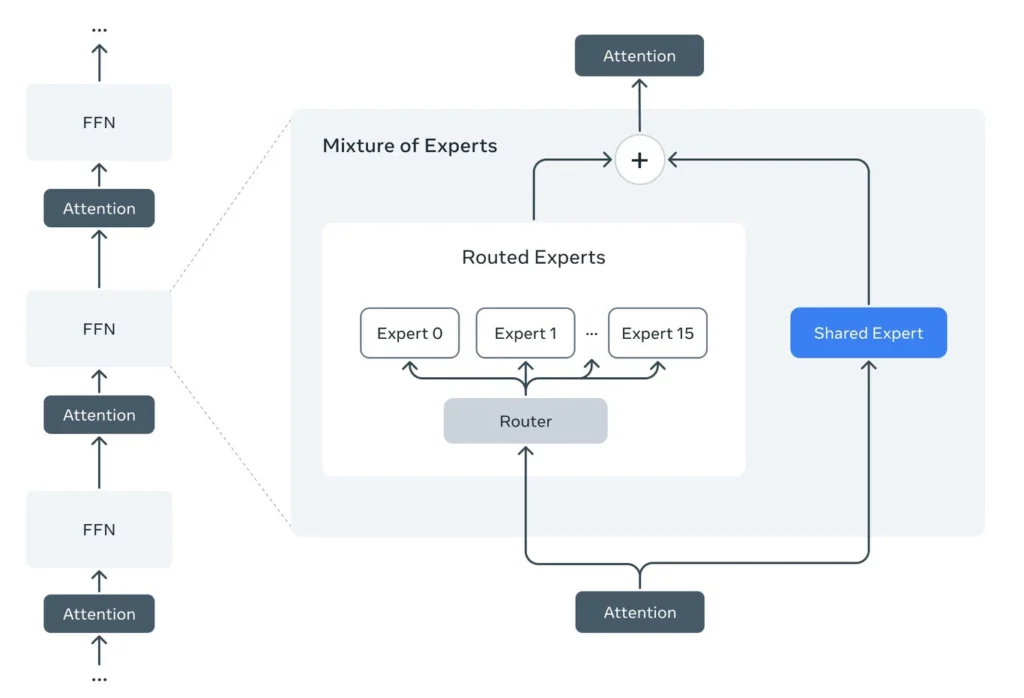

Se trata de la primera generación de modelos de Meta con arquitectura «mixture of experts» (MoE), una estrategia que permite que el modelo sea más eficiente computacionalmente, tanto durante su entrenamiento como en la resolución de tareas reales.

¿Y cómo funciona esto exactamente? Olvídate del clásico “modelo gigante que hace de todo”. En su lugar, Llama 4 divide las tareas en subtareas específicas y las asigna a distintos “expertos”: modelos más pequeños, cada uno especializado en un tipo de operación. Es como tener un ejército de mini-IAs trabajando en conjunto, cada una haciendo lo que mejor sabe hacer.

Un ejemplo concreto: el modelo Maverick, con un total de 400.000 millones de parámetros, solo utiliza 17.000 millones de parámetros activos en cada consulta. Es decir, activa solo lo necesario entre sus 128 expertos, ahorrando recursos sin sacrificar precisión ni complejidad en la respuesta.

¿Traducción práctica? Esto no solo hace que Llama 4 sea más barato de ejecutar, también lo hace más rápido, más escalable y más adaptable. Una arquitectura pensada para el presente, pero sobre todo para el futuro.

Varios modelos, varias bestias con propósito

Meta no lanza un solo modelo. Este enfoque, lejos de ser una moda, marca el camino hacia IAs más escalables, sostenibles y potentes. Un salto evolutivo serio. Lanza un ecosistema completo, adaptado a diferentes tipos de uso. Te los presentamos:

- Llama 4 Scout: el más ágil para trabajar con textos e imágenes largas. Tiene una ventana de contexto de 10 millones de tokens, cuenta con 17.000 millones de parámetros activos distribuidos, distribuidos en 16 expertos, ideal para analizar documentos extensos, líneas de código kilométricas o imágenes en conjunto.

- Llama 4 Maverick: tiene 17.000 millones de parámetros activos distribuidos en este caso entre 128 expertos, pensado como asistente general, está diseñado para conversaciones, redacción creativa, codificación y razonamiento multilingüe. Se planta de frente ante modelos como GPT-4o y Gemini 2.0, y según los tests de Meta, los supera en varios frentes clave. Nada mal para un recién llegado.

- Llama 4 Behemoth: el tanque. Una IA con casi dos billones de parámetros, 288.000 millones de parámetros activos y 16 expertos, el más potente hasta la fecha y uno de los modelos de lenguaje más avanzados. Aún en fase de entrenamiento, pero que ya ha mostrado músculo suficiente como para dejar atrás a GPT-4.5 y compañía en áreas técnicas y científicas.

Y todos ellos comparten un nuevo enfoque arquitectónico que merece mención aparte…

Llama 4 Maverick, GPT-4.5, Gemini 2.5 Pro y Claude 3.7 Sonnet

Esta comparativa destaca aspectos clave como la arquitectura, la ventana de contexto, los parámetros activos y las capacidades multimodales.

| Característica | Llama 4 Maverick | GPT-4.5 | Gemini 2.5 Pro | Claude 3.7 Sonnet |

|---|---|---|---|---|

| Arquitectura | Mixture of Experts (MoE) | No especificada | No especificada | Razonamiento híbrido |

| Parámetros Totales | 400 mil millones | No especificado | No especificado | No especificado |

| Parámetros Activos | 17 mil millones distribuidos entre 128 expertos | No especificado | No especificado | No especificado |

| Ventana de Contexto | No especificada | 128 mil tokens | 1 millón de tokens (próximamente 2 millones) | 200 mil tokens |

| Capacidades Multimodales | Texto, imagen y vídeo | Texto e imagen | Texto, imagen, audio y vídeo | Principalmente texto |

| Disponibilidad | Integrado en WhatsApp, Messenger e Instagram en 40 países (excepto UE) | Disponible a través de OpenAI | Disponible gratuitamente para todos los usuarios | Disponible a través de Anthropic y plataformas asociadas |

| Código Abierto | Sí, con restricciones para entidades comerciales con más de 700 millones de usuarios | No | No | No |

| Fecha de Lanzamiento | 5 de abril de 2025 | 13 de mayo de 2024. Actualización prevista para 2025 | 25 de marzo de 2025 | 24 de febrero de 2025 |

| Fortalezas Destacadas | Eficiencia computacional y comprensión visual avanzada | Mejoras en precisión y comprensión contextual | Razonamiento avanzado y procesamiento multimodal | Precisión factual y comunicación empresarial |

Notas Adicionales

- Llama 4 Maverick: Utiliza una arquitectura Mixture of Experts (MoE) que mejora la eficiencia al activar solo los expertos necesarios para cada tarea. The Verge

- GPT-4.5: Representa el esfuerzo continuo de OpenAI por mantenerse a la cabeza en la carrera por la inteligencia artificial. En un entorno donde gigantes como Google, Meta y Anthropic invierten agresivamente, este modelo destaca por su equilibrio entre potencia, eficiencia y aplicaciones prácticas. Más allá de generar texto, se perfila como una herramienta clave para integrar la IA en productos cotidianos de forma segura y útil. Axios

- Gemini 2.5 Pro: Destaca por su amplia ventana de contexto y capacidades multimodales, incluyendo procesamiento de voz y vídeo. DocsBot AI

- Claude 3.7 Sonnet: Primer modelo de razonamiento híbrido que permite controlar el nivel de razonamiento aplicado en la resolución de problemas. WIRED

¿Open source? Sí, pero Europa no está invitada

Aquí viene la letra pequeña. Aunque Meta presume de que Llama 4 es open source y puede descargarse ya desde su web y plataformas como Hugging Face, la realidad es que los usuarios de la Unión Europea están fuera de juego.

El motivo: la legislación europea sobre inteligencia artificial y protección de datos. Demasiados riesgos legales, demasiadas regulaciones que cumplir. Resultado: si estás en España, Francia o Alemania, por ahora ni Llama 4 Scout ni Maverick están disponibles para ti.

¿Irónico? Bastante. Meta, el adalid de la globalización tecnológica, dejando fuera a más de 400 millones de personas por un tema legal. Pero así está el patio.

Menos censura, más polémica (y más poder)

Otra gran diferencia respecto a modelos anteriores: Llama 4 se calla menos la boca. Meta ha ajustado la IA para que no rechace sistemáticamente hablar de temas sociales o políticos como ocurría antes. Esto significa respuestas más completas, más valientes… pero también con más riesgo.

Además, aseguran que el sistema es más “equilibrado” al decidir qué temas abordar y cuáles no. ¿Libre expresión o control medido? La línea es delgada, pero el mensaje está claro: Meta quiere una IA que hable más, no menos.

Ya lo estás usando (aunque no lo sepas)

Lo más inquietante de todo: Llama 4 ya vive dentro de tus aplicaciones. El círculo azul de Meta AI ya está activo en chats de WhatsApp, Instagram y Messenger en 40 países (aunque no en la UE) y está utilizando estos nuevos modelos para ayudarte a responder mensajes, crear textos, entender imágenes… Todo desde la comodidad de tu móvil.

Eso sí, las funciones más avanzadas siguen limitadas al inglés y al mercado estadounidense. Pero si Meta ha demostrado algo en estos años es que cuando entra en algo, lo hace para quedarse.

El verdadero rival de OpenAI podría ser Zuck

Mientras todos miraban a OpenAI y su GPT-4.5, Meta ha lanzado su ataque por sorpresa, y con un arsenal tan variado como potente. Llama 4 no es solo una actualización: es una declaración de intenciones. Es una plataforma pensada para escalar, para integrarse, para medirse con los más grandes… y en algunos aspectos, para superarlos.

Con su enfoque MoE, su vocación multimodal, su músculo open source y su estrategia de integración directa en las apps del día a día, Meta deja claro que quiere convertirse en el estándar. No solo de código abierto, sino de experiencia de usuario.

Y mientras en Europa seguimos debatiendo sobre licencias, ética y legislación, el resto del mundo ya está hablando con Llama 4. Viendo con sus ojos. Pensando con su cerebro artificial.

Esto ya no va de futuro. Esto va del presente. Y Meta está apostando a lo grande.