Si alguna vez os habéis peleado con un OCR intentando escanear un documento complejo con tablas, columnas y notas al margen, sabéis el desastre que puede ser. Las máquinas suelen leer de arriba abajo y de izquierda a derecha, sin entender la lógica del documento. Pues bien, DeepSeek acaba de anunciar que ha solucionado esto de una forma brillante: enseñando a la IA a leer como lo hacemos nosotros.

DeepSeek ha anunciado hoy el lanzamiento de DeepSeek-OCR 2, su nuevo modelo de reconocimiento de documentos. Esta actualización no es un simple retoque, sino una reingeniería profunda centrada en cómo la máquina entiende la estructura visual de un documento antes de ponerse a leer el texto.

El objetivo es ambicioso: que las máquinas se asemejen más a la lógica de lectura visual humana.

El problema de leer como un robot

Los modelos de OCR tradicionales procesan las imágenes en un orden de cuadrícula fijo, de arriba a la izquierda a abajo a la derecha. Esto funciona para un texto plano, pero es un desastre para documentos con diseños complejos (tablas, fórmulas, notas), donde los humanos leemos dando «saltos» basados en la lógica y la semántica, no solo en la posición espacial.

La solución: DeepEncoder V2 y el «flujo causal visual»

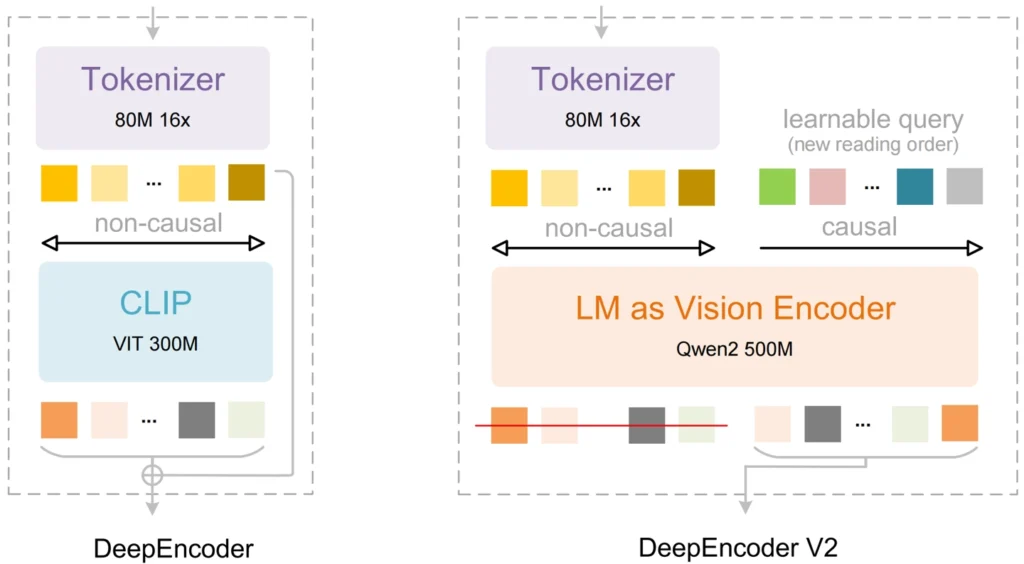

La clave de DeepSeek-OCR 2 es su nueva estructura de codificador, llamada DeepEncoder V2. Esta estructura permite ajustar dinámicamente el orden de procesamiento de la información visual basándose en la semántica de la imagen, clasificando inteligentemente el contenido antes de reconocer el texto.

¿Cómo lo hace? Introduciendo el concepto de «flujo causal visual». El nuevo codificador sustituye el módulo anterior basado en CLIP por una estructura similar a la de un modelo de lenguaje e introduce tokens de consulta de flujo causal aprendibles.

El proceso es fascinante:

- Percepción Global: La información visual sin procesar se percibe globalmente mediante atención bidireccional (la IA «mira» todo el documento a la vez).

- Reordenación Inteligente: Los nuevos tokens de consulta se ordenan secuencialmente mediante atención causal, reorganizando dinámicamente el orden de los elementos visuales según su lógica.

- Decodificación: Solo los tokens reorganizados causalmente se envían al decodificador para generar el texto final.

A pesar de esta complejidad, el modelo mantiene un nivel similar de sobrecarga de recursos que su predecesor, utilizando entre 256 y 1120 tokens visuales por página.

Resultados: Más precisión y mejor orden de lectura

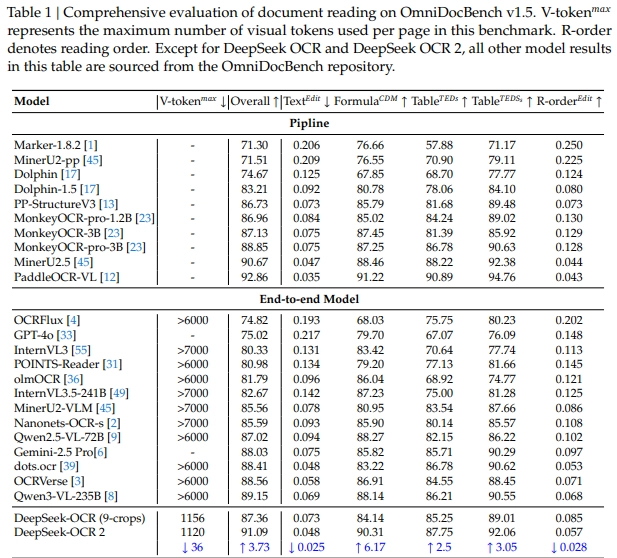

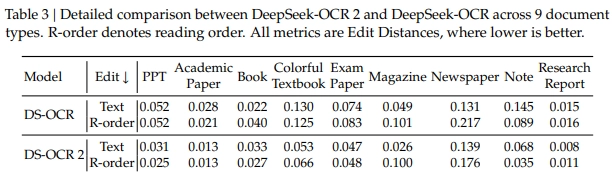

En el benchmark OmniDocBench v1.5, que incluye documentos complejos en chino e inglés, DeepSeek-OCR 2 logró una puntuación general del 91,09%, una mejora del 3,73% respecto a la versión anterior.

Lo más impresionante es la mejora en la precisión del orden de lectura, donde la distancia de edición disminuyó significativamente de 0,085 a 0,057, demostrando que el modelo entiende mucho mejor la estructura del contenido. Además, ha mejorado su estabilidad en entornos de producción, reduciendo la tasa de repetición en registros de usuarios y datos PDF.

La opinión Final del Gurú

Técnicamente, DeepSeek-OCR 2 es un avance conceptual brillante. Romper con la lectura secuencial espacial y pasar a una lectura secuencial semántica («causal») es exactamente lo que necesitaban los sistemas OCR para dar el siguiente salto de calidad.

Al imitar el proceso cognitivo humano de «escanear globalmente y luego enfocar secuencialmente según la lógica», este modelo promete ser mucho más robusto frente a documentos del mundo real que nunca están perfectamente maquetados. No se trata solo de reconocer mejor las letras, sino de entender qué es un título, qué es una celda de una tabla y qué es una nota al pie, y leerlos en el orden correcto.

Es un paso fundamental hacia una IA que realmente comprenda documentos, no que solo extraiga caracteres. ¿Qué te parece la nueva función implementada? ¡Cuéntanoslo en los comentarios! Y no te olvides de seguir a Gurú Tecno en YouTube, Instagram y Facebook.