Llevamos tiempo viendo cómo la IA («el cerebro») avanza a pasos agigantados con modelos tipo GPT, y cómo la robótica humanoide («el cuerpo») se vuelve cada vez más ágil con empresas como Boston Dynamics o Tesla. Pero faltaba el eslabón perdido: el sistema nervioso que conecte ambos mundos de forma eficiente. Unitree Robotics, conocida por sus perros robot y su humanoide G1, acaba de dar un golpe sobre la mesa al liberar el código de ese eslabón perdido.

Unitree anuncia un hito fundamental para la comunidad robótica: la apertura del código fuente de su gran modelo UnifoLM-VLA-0

No estamos ante otro modelo de lenguaje más que solo «habla». Este es un modelo de Visión-Lenguaje-Acción (VLA) a gran escala. ¿Su objetivo? Superar las limitaciones de las IAs actuales que solo entienden fotos y texto, para crear un verdadero «cerebro corpóreo» dotado de sentido común físico, capaz de interactuar con el mundo real a través de un cuerpo robótico.

Ingeniería VLA: Cómo enseñar a una IA a moverse en 3D

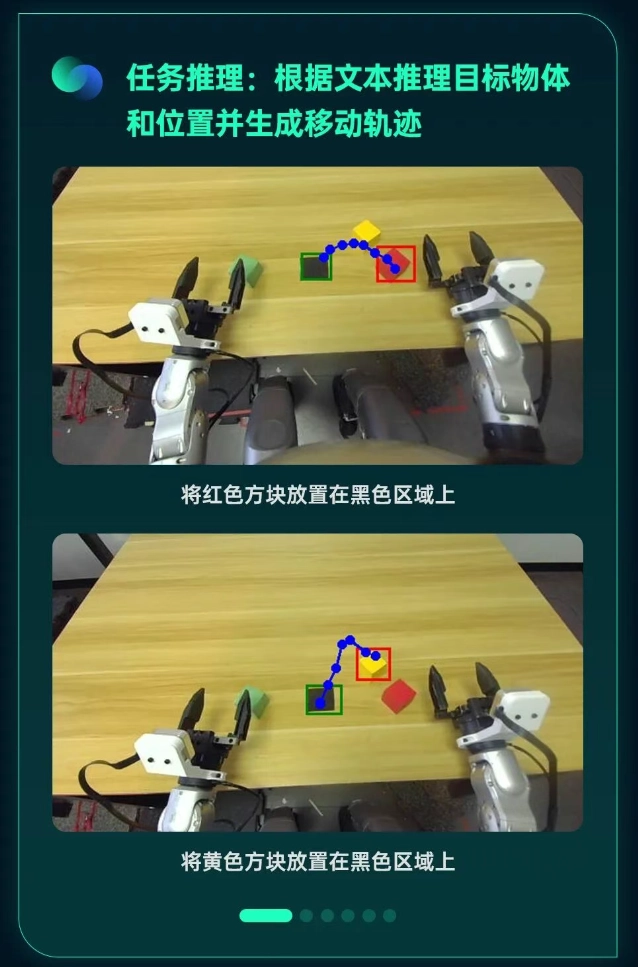

El desafío técnico es monumental: una IA debe entender una instrucción en texto («coge la taza roja»), localizarla visualmente en un espacio 3D complejo y luego planificar los movimientos físicos para agarrarla sin romperla.

Para lograrlo, Unitree ha construido este sistema sobre los hombros de gigantes, basándose en el modelo de código abierto Qwen2.5-VL-7B. A partir de ahí, han realizado un trabajo de ingeniería brutal:

- Fusión Espacial Profunda: El modelo no solo «ve» píxeles. Ha sido preentrenado fusionando instrucciones de texto con detalles espaciales 2D y 3D, mejorando drásticamente su conciencia del entorno.

- Dataset Multitarea Masivo: Unitree construyó un conjunto de datos que incluye detección y segmentación 2D/3D, razonamiento de ubicación espacial y predicción de trayectorias. Esto alinea el espacio geométrico real con la lógica semántica de las órdenes.

- Eficiencia de Datos Reales: Para enseñar al robot a moverse, Unitree depuró sistemáticamente el conjunto de datos. Sorprendentemente, utilizaron solo unas 340 horas de datos de máquinas reales para el entrenamiento de predicción de movimiento. El modelo integra restricciones dinámicas para entender la interacción física y planificar movimientos a largo plazo.

Resultados: Un solo cerebro para dominarlos a todos

El proceso dio lugar primero al modelo base UnifoLM-VLM-0, que ya demostró en pruebas comparativas un rendimiento en comprensión espacial comparable a gigantes como Gemini-Robotics-ER 1.5 de Google en ciertos modos.

Pero la verdadera revolución es el modelo final, UnifoLM-VLA-0, que integra la capacidad de acción (un «ActionHead»).

- En simulación: Alcanzó un rendimiento casi óptimo en la prueba de referencia LIBERO.

- En el mundo real (Robot Unitree G1): Aquí es donde la teoría se encuentra con la realidad. Utilizando una única red neuronal (política única), el robot humanoide G1 fue capaz de completar de forma estable 12 tareas operativas complejas distintas.

- Robustez: El modelo demostró una buena capacidad antiinterferencias, manteniendo la ejecución incluso bajo condiciones de perturbación externa.

Para los desarrolladores e ingenieros interesados, Unitree ha puesto todo a disposición:

- Página del proyecto: https://unigen-x.github.io/unifolm-vla.github.io/

- Código fuente en GitHub: https://github.com/unitreerobotics/unifolm-vla

La opinión final del Gurú: análisis técnico

Técnicamente y estratégicamente, este movimiento de Unitree es brillante y disruptivo. Al hacer de código abierto un modelo VLA (Visión-Lenguaje-Acción) tan maduro, están democratizando el acceso a la robótica humanoide de alto nivel, un campo hasta ahora reservado a laboratorios con presupuestos multimillonarios.

El aspecto más impresionante desde el punto de vista de la IA es la generalización de tareas con una política única. Lograr que un solo modelo neuronal ejecute 12 tareas físicas complejas y distintas en un robot real, sin necesidad de programar cada tarea por separado, es el Santo Grial de la robótica generalista. Además, la eficiencia demostrada al usar solo 340 horas de datos reales sugiere que su pipeline de entrenamiento híbrido (simulación + real) está increíblemente bien afinado. Unitree no solo vende hardware; ahora provee el cerebro estándar para que la comunidad construya sobre él.

Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.