La semana pasada, el mundo tecnológico se arrodilló ante la llegada de GPT-5, la nueva bestia de OpenAI que promete revolucionarlo todo. Vimos sus capacidades para programar, para razonar a nivel de doctorado… una auténtica genialidad. Pero toda genialidad tiene un precio. Y el de GPT-5 no se mide solo en los 20 dólares de la suscripción mensual; se mide en vatios. Y la factura de la luz es para echarse a temblar.

Mientras OpenAI destacaba las capacidades innovadoras de su nuevo modelo, un grupo de expertos y académicos ha empezado a señalar el elefante en la habitación: estas nuevas y asombrosas capacidades exigen una cantidad de energía demencial. Bienvenidos a la resaca energética de la superinteligencia.

Los números de la factura eléctrica

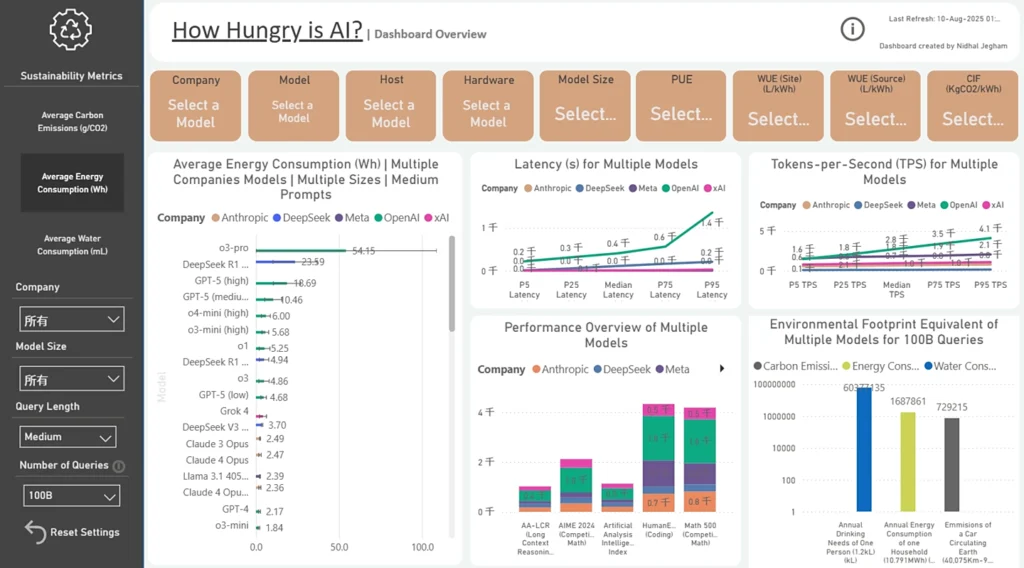

Esto no es especulación. Son los primeros datos de investigadores del Laboratorio de IA de la Universidad de Rhode Island, y son brutales. Una sola respuesta de longitud media (unos 1.000 tokens) de GPT-5 consume de media 18 vatios-hora (Wh), con picos que pueden alcanzar los 40 Wh.

Para ponerlo en perspectiva, es como tener una bombilla incandescente de las antiguas encendida durante 18 minutos por cada pregunta compleja que le haces. Es un consumo significativamente mayor que el de casi todos los demás modelos del mercado, superando con creces a su predecesor, GPT-4o.

Y aquí es donde la cifra se vuelve demencial. ChatGPT gestiona aproximadamente 2.500 millones de peticiones al día. Si todas ellas las procesara GPT-5 con ese consumo medio, la energía total gastada en un solo día sería suficiente para alimentar a 1,5 millones de hogares estadounidenses. No estamos hablando de un superordenador, estamos hablando de una red eléctrica paralela dedicada a que la IA nos escriba correos y nos dé recetas de cocina.

El secretismo de OpenAI: el elefante en la habitación

Y lo peor de todo es el silencio y la opacidad de OpenAI. La compañía no ha publicado ni un solo dato oficial sobre el consumo energético de sus modelos desde el arcaico GPT-3 en 2020. No sabemos cuántos parámetros tiene GPT-5 (se especula que es varias veces más grande que GPT-4), no sabemos cuántos litros de agua usan para refrigerar sus centros de datos… no sabemos nada.

Sam Altman, su CEO, suelta cifras vagas en su blog sin ninguna documentación que las respalde, mientras investigadores de todo el mundo claman por una «transparencia total» sobre el impacto ambiental. Pero la transparencia no parece ser parte del modelo de negocio cuando las cifras son tan alarmantes. La investigación de otras empresas como Mistral AI ya ha confirmado una «fuerte correlación» entre el tamaño del modelo y su consumo energético. Más inteligencia, más gasto.

La paradoja de la inteligencia artificial

GPT-5 es una proeza de la ingeniería de software. Su capacidad para el «pensamiento profundo» es un salto cuántico. Pero ese salto se paga con un coste energético igualmente cuántico. Es la gran paradoja de la IA actual: para crear una inteligencia que pueda, quizás, ayudarnos a resolver problemas como el cambio climático, estamos construyendo máquinas con una huella de carbono que agrava ese mismo problema.

La carrera por la superinteligencia no es solo una competición de algoritmos; es una carrera de consumo de recursos a una escala nunca vista. Y OpenAI, como líder de la manada, tiene la responsabilidad moral de ser transparente con el verdadero coste de su magia. Porque una inteligencia que no es sostenible no es, al final, tan inteligente.

¿Es el brutal consumo energético el precio inevitable que debemos pagar por una IA más avanzada? ¿O deberían las empresas como OpenAI ser obligadas a ser transparentes con su impacto ambiental? El debate sobre el coste oculto de la IA está servido. Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.