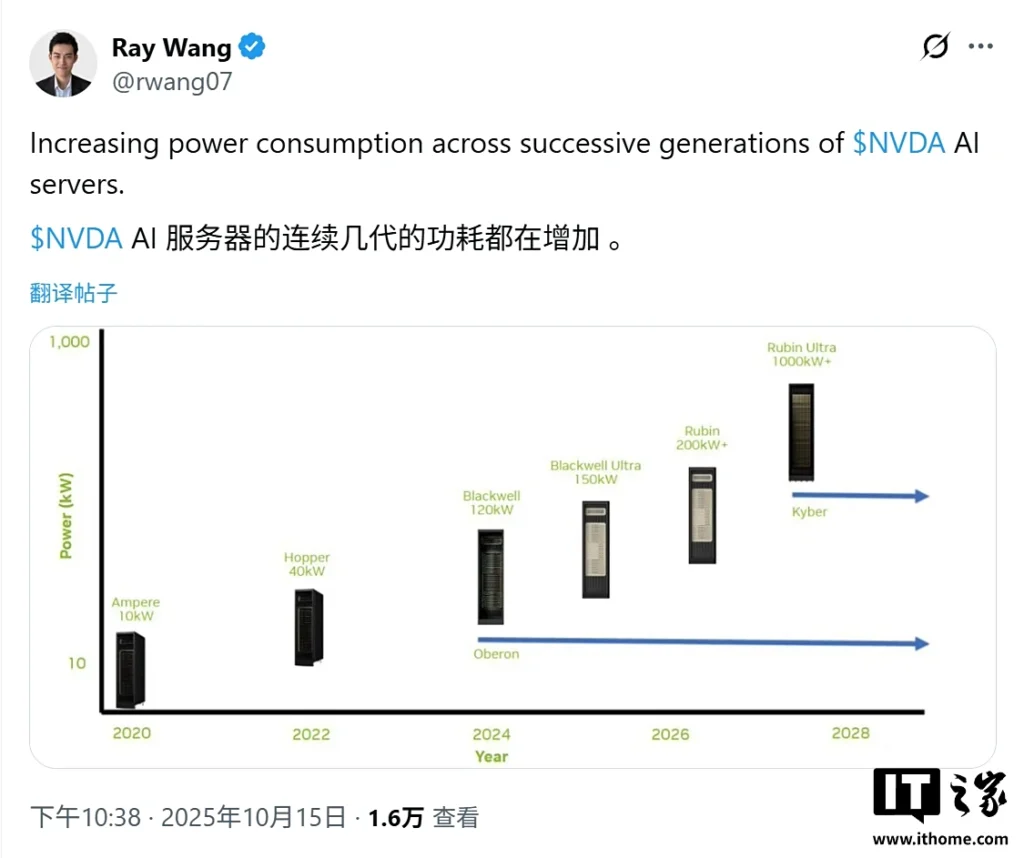

La inteligencia artificial no solo está devorando datos… también electricidad. El analista tecnológico Ray Wang advirtió recientemente en X (Twitter) que el consumo energético de los servidores de IA de Nvidia está creciendo a un ritmo simplemente insostenible. Según sus datos, el salto desde Ampere (2020) hasta la futura arquitectura Kyber (2028) supondrá un incremento de x100 en el consumo eléctrico por rack. Sí, has leído bien: cien veces más.

De 10 kW a más de 1.000 kW: la escalada eléctrica de Nvidia

En 2020, un servidor basado en Ampere consumía unos 10 kW.

Con Hopper, esa cifra se cuadruplicó hasta 40 kW.

Los sistemas Blackwell alcanzan ya los 120-150 kW, y los Rubin Ultra proyectados para 2026 llegarán a 200-1.000 kW por rack.

El siguiente salto, Kyber, podría romper todas las escalas.

El problema es doble:

– Cada rack contiene más GPU ultra potentes.

– Cada GPU tiene un TDP (Thermal Design Power) mucho mayor que la generación anterior.

En resumen, Nvidia está construyendo auténticos hornos de cómputo digital.

Interconexiones, refrigeración y el monstruo invisible

El consumo no proviene solo de las GPU. Las nuevas tecnologías de interconexión NVLink y NVSwitch, los modos de carga sostenida y el diseño avanzado de racks están provocando un aumento exponencial en los requisitos energéticos.

Los centros de datos de hiperescala (de Google, Meta o Microsoft) ahora requieren gigavatios enteros para alimentar sus granjas de IA.

Para ponerlo en contexto: 1 gigavatio equivale al consumo eléctrico de un millón de hogares estadounidenses. Y cada nuevo centro de datos de IA podría devorar tanta energía como un país mediano entero.

La AIE lanza la alarma: la IA duplicará el consumo mundial de electricidad antes de 2030

Según la Agencia Internacional de la Energía (AIE), la inteligencia artificial por sí sola podría duplicar la demanda mundial de electricidad en apenas cinco años.

Esto implica no solo una presión brutal sobre las redes eléctricas, sino también un aumento de costes para los ciudadanos que viven cerca de estas megainstalaciones. El sueño de la IA tiene un lado oscuro: una factura eléctrica que no deja de crecer.

El futuro: más potencia, menos sostenibilidad

Mientras Nvidia lidera la revolución de la IA con sus chips Blackwell, Rubin y Kyber, el planeta se enfrenta a un dilema mayúsculo: ¿podremos sostener energéticamente la fiebre de la inteligencia artificial?

Conclusión

La inteligencia artificial está empujando la infraestructura global a un límite físico y energético sin precedentes. El salto de Nvidia desde Ampere (10 kW) hasta Rubin Ultra (1.000 kW) en apenas una década no solo representa un avance en potencia de cómputo, sino también una crisis de eficiencia estructural: los algoritmos crecen más rápido que la capacidad de generar y disipar energía.

Cada nueva generación de GPU multiplica su densidad térmica, su ancho de banda de memoria y su capacidad de interconexión, pero apenas mejora en rendimiento por vatio (performance per watt). El resultado es un sistema donde el rendimiento bruto escala exponencialmente, mientras la eficiencia energética apenas crece linealmente.

A este ritmo, los centros de datos de IA no solo necesitarán más electricidad que países enteros: exigirán redes eléctricas dedicadas, refrigeración líquida a gran escala y una redefinición completa de la arquitectura de cómputo.

El futuro de la IA no dependerá únicamente de la inteligencia de los modelos, sino de la inteligencia con la que gestionemos la energía que los alimenta. Porque si seguimos escalando sin límites, el cuello de botella no será el silicio… será el megavatio. El debate está servido. Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.