En la brutal guerra por el hardware de la Inteligencia Artificial, hay un rey indiscutible (NVIDIA), un aspirante que viene con todo (AMD) y un viejo emperador que intenta no quedarse atrás (Intel). Mientras los dos primeros se dan de hostias con el silicio, Intel está librando una batalla más silenciosa pero igual de crucial: la del software. Y su última jugada es una actualización muy seria para su plataforma de IA, Project Battlematrix.

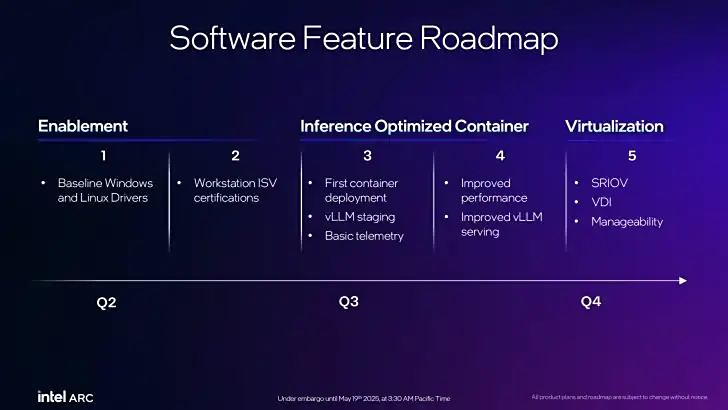

La compañía acaba de lanzar LLM Scaler v1.0, una nueva versión de su contenedor de software diseñado para exprimir al máximo sus tarjetas gráficas Arc Pro. No es un simple parche. Es una optimización profunda que, según ellos, puede mejorar el rendimiento general de una estación de trabajo multi-GPU hasta en un 80%.

La cruda realidad: el hardware no es nada sin un buen software

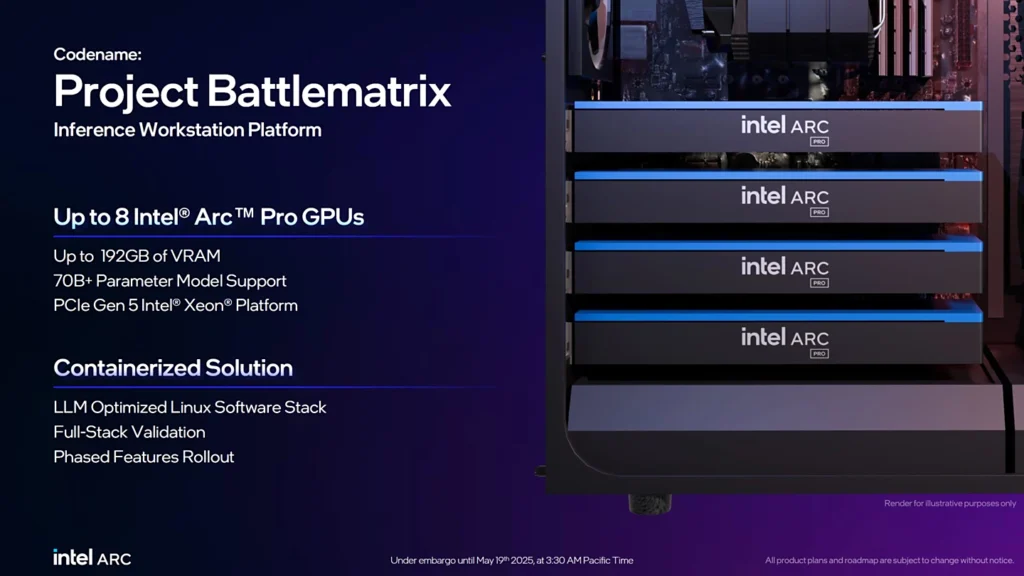

Para entender este movimiento, hay que entender la posición de Intel. En mayo, presentaron sus tarjetas Arc Pro B50 y B60 y su plataforma Project Battlematrix, una estación de trabajo que puede albergar hasta 8 de estas GPUs para ejecutar modelos de IA de tamaño medio (hasta 150.000 millones de parámetros). El hardware es decente, pero saben que no pueden competir en potencia bruta con una H100 de NVIDIA.

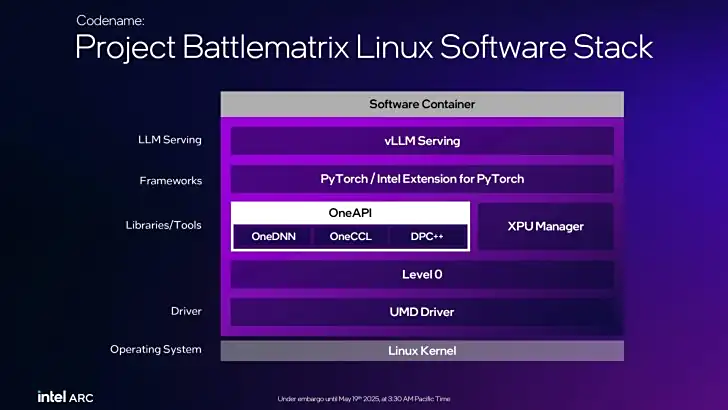

¿Cuál es su única opción? Ser los mejores en el software. Optimizar cada capa, desde los drivers hasta el framework, para que su hardware rinda por encima de sus posibilidades. Y eso es exactamente lo que hace LLM Scaler.

Desgranando la actualización: ¿dónde está la magia?

Esta nueva versión v1.0 es una lección de optimización de bajo nivel, centrada en el popular framework de inferencia vLLM:

- Rendimiento mejorado: Han conseguido que modelos grandes (70B) con secuencias largas rindan hasta 4,2 veces más rápido que antes. Para modelos más pequeños, la mejora es de un 10% general.

- Menos memoria: Introducen «cuantificación en línea en capas», un nombre rimbombante para una técnica que reduce drásticamente el uso de memoria de vídeo, permitiendo que modelos más grandes quepan en la VRAM disponible.

- Herramientas de nivel empresarial: Integran la herramienta XPU Manager para gestionar la energía de las GPUs, actualizar el firmware y hacer diagnósticos, funciones cruciales para entornos profesionales.

- Comunicación directa: Aprovechan al máximo la transmisión de datos punto a punto (P2P) a través de PCIe entre las múltiples GPUs, eliminando cuellos de botella y logrando esa mejora de hasta el 80% en el rendimiento general del sistema.

La guerra de los ecosistemas

Lo que Intel está haciendo con Project Battlematrix y su pila de software (basada en su arquitectura abierta OneAPI) es una jugada a largo plazo. Saben que la guerra de la IA no la ganará solo el que tenga el chip más potente, sino el que ofrezca el ecosistema de software más completo, abierto y fácil de usar para los desarrolladores.

Están construyendo su propio jardín, intentando atraer a los desarrolladores con herramientas de gestión, de evaluación de rendimiento (OneCCL) y compatibilidad con los estándares de la industria. Es una batalla cuesta arriba contra el ecosistema CUDA de NVIDIA, que lleva años de ventaja, pero es la única batalla que pueden librar.

Esta actualización es un paso importante y necesario. Demuestra que Intel no se rinde y que entiende que, para competir en la era de la IA, no basta con vender silicio. Tienes que vender una solución completa, un paquete de hardware y software perfectamente integrado. La pregunta es si podrán iterar lo suficientemente rápido para alcanzar a una NVIDIA que, ahora mismo, parece inalcanzable.

¿Crees que la estrategia de software de Intel puede ayudarles a competir contra el dominio de NVIDIA y AMD? ¿Es el ecosistema abierto de OneAPI una alternativa real a CUDA? El futuro de la computación de IA se juega en el software. Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.