La inteligencia artificial está cruzando una nueva frontera. Según un informe del NCC Group, la tecnología de falsificación de voz en tiempo real ha alcanzado un punto crítico: permite imitar voces humanas de manera instantánea y casi perfecta, con una tasa de engaño cercana al 100%.

Deepfake Vishing: el fraude sonoro del futuro ya está aquí

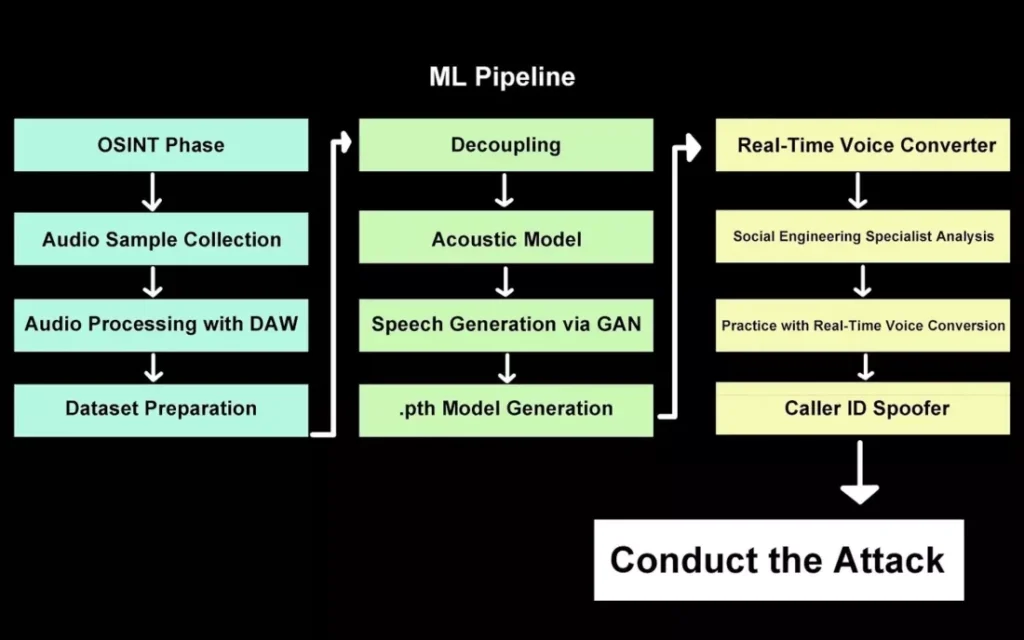

El proceso —denominado deepfake vishing— utiliza modelos de IA entrenados con muestras de voz obtenidas de grabaciones públicas o filtradas (lo que se conoce como fase OSINT). Una vez procesados los datos, el sistema genera una réplica de voz digital con un nivel de realismo tan alto que puede engañar incluso a oyentes entrenados.

El esquema técnico, revelado en la investigación, sigue tres fases:

- Recolección y preparación del audio:

- Extracción de muestras de voz (redes sociales, entrevistas, etc.)

- Limpieza del sonido con software de audio profesional (DAW)

- Creación de un conjunto de datos estructurado para entrenamiento

- Pipeline de IA (Machine Learning):

- Separación de componentes acústicos (decoupling)

- Entrenamiento de un modelo acústico

- Generación de voz sintética mediante una GAN (Generative Adversarial Network)

- Creación del modelo final (.pth)

- Ejecución del ataque:

- Conversión de voz en tiempo real

- Análisis de ingeniería social

- Práctica con la voz clonada

- Suplantación de identificador de llamada (Caller ID Spoofing)

El resultado final: una llamada falsa con voz idéntica a la del objetivo y sin retardo perceptible.

Un avance técnico impresionante (y aterrador)

La IA empleada logró latencias inferiores a 0,5 segundos usando una simple GPU Nvidia RTX A1000, una tarjeta gráfica común en portátiles.

Esto marca una diferencia brutal frente a las herramientas antiguas, que requerían minutos de preprocesamiento y eran fácilmente detectables por su sonido robótico o falta de sincronía.

El sistema incluso permite modular tono, velocidad y emoción sobre la marcha, adaptándose al contexto de la conversación. En otras palabras, una IA puede mantener una llamada en tiempo real haciéndose pasar por cualquier persona, desde un jefe hasta un familiar.

Fraudes que ya engañan a casi todos

El consultor Pablo Alobera del NCC Group explicó que en pruebas controladas (y con consentimiento), los sistemas de voz IA combinados con suplantación de Caller ID lograron engañar a los participantes casi en el 100% de los intentos.

La diferencia clave respecto a generaciones anteriores es la naturalidad emocional: respiraciones, pausas y microentonaciones que hacen que el oído humano no detecte el engaño.

“Estamos entrando en una era donde ni siquiera una llamada de voz puede considerarse prueba de identidad”, advirtió Alobera.

Los deepfakes de video aún están lejos del nivel de realismo

Aunque el audio ya se ha perfeccionado, los deepfakes de video en tiempo real todavía presentan problemas:

- Expresiones faciales inconsistentes

- Movimientos desincronizados

- Emociones artificiales

Incluso con sistemas avanzados como Alibaba WAN 2.2 Animate o Google Gemini Flash 2.5 Image, los resultados aún delatan falsificaciones en detalles sutiles.

Expertos piden nuevos mecanismos de autenticación

Trevor Wiseman, fundador de la empresa de seguridad de IA The Circuit, afirma que esta tecnología ya ha provocado pérdidas económicas reales, incluyendo casos en los que empresas enviaron equipos a direcciones falsas tras ser engañadas por un video o una llamada deepfake.

Wiseman sugiere implementar códigos secretos o señales preacordadas, similares a los gestos de béisbol, como forma de autenticación personal durante comunicaciones críticas.

“Los métodos tradicionales de verificación —llamadas, videollamadas, contraseñas de voz— ya no son fiables. Sin nuevas defensas, los ataques de ingeniería social impulsados por IA serán imparables.”

Conclusión Gurú Tecno

La falsificación de voz en tiempo real marca un punto de inflexión en la ciberseguridad. Lo que antes parecía ciencia ficción, hoy está al alcance de cualquiera con una GPU y un modelo de IA libre.

Esta tecnología tiene enormes aplicaciones legítimas (como doblaje instantáneo o accesibilidad), pero también un potencial devastador en manos de ciberdelincuentes.

El reto, a partir de ahora, será desarrollar mecanismos de autenticación humanos y digitales capaces de distinguir entre una voz real y una IA perfectamente disfrazada. En el futuro, escuchar no será suficiente para creer. Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.