Si usáis ChatGPT a diario, preparaos, porque la forma en que interactuáis con la IA más famosa del mundo acaba de cambiar radicalmente, y no a todo el mundo le va a gustar el nuevo «portero de discoteca».

OpenAI se ha puesto seria (por fin, dirán muchos) con la protección de los menores en su plataforma. Pero la solución que han implementado es tan tecnológica como polémica: una IA que intenta adivinar tu edad y que, si se equivoca, te va a pedir una prueba biométrica para dejarte pasar.

El «Gran Hermano» algorítmico que decide si eres adulto

La presión social y las duras críticas que OpenAI ha recibido por el impacto de ChatGPT en los adolescentes —incluyendo casos trágicos vinculados al uso del chatbot y la generación de contenido inapropiado— han surtido efecto. La compañía ha introducido un sistema de verificación de edad diseñado para identificar a los menores y aplicar restricciones de contenido razonables, bloqueando temas sexuales o violentos.

Hasta aquí, todo suena lógico y necesario. El problema es el «cómo».

Olvídate de simplemente marcar una casilla diciendo que tienes más de 18 años. La nueva funcionalidad utiliza un algoritmo de IA que analiza tu cuenta en busca de «señales de comportamiento».

Según ha detallado la propia OpenAI este martes, este sistema no solo mira la edad que declaraste, sino que cruza datos como la antigüedad de tu cuenta y las horas del día en las que estás activo para determinar si eres un usuario joven o un adulto. Es decir, una IA está juzgando tus hábitos para decidir tu edad.

La polémica: «Culpable hasta que demuestres lo contrario con un selfie»

Aquí es donde la comunidad se ha levantado en armas. Como cualquier sistema de IA, este predictor de edad no es infalible y tiene fallos. El problema es la solución que OpenAI ha impuesto para corregir estos errores.

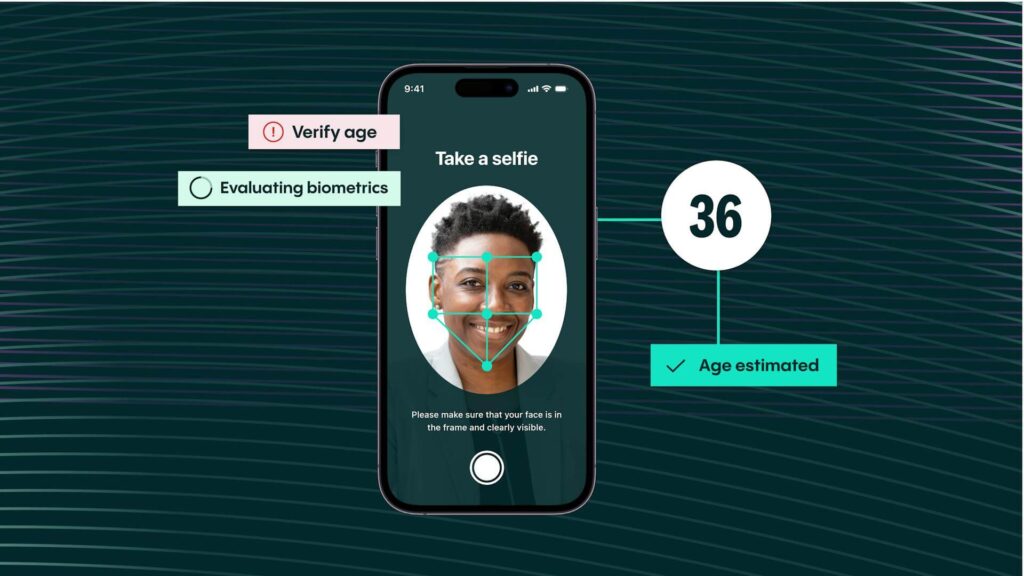

Si la IA te identifica erróneamente como menor de edad, limitando tu acceso, la única forma de restablecer tu cuenta como adulto es enviar una foto selfie. Esta verificación no la hace OpenAI directamente, sino un socio externo llamado Persona.

La controversia está servida: usuarios adultos se ven obligados a compartir datos biométricos sensibles (su rostro) con terceros simplemente porque un algoritmo ha fallado al analizar su comportamiento. Es un cambio drástico respecto a la política anterior, donde nunca se forzaba el envío de una foto para verificar la edad.

El contexto: preparando el terreno para el ChatGPT «para adultos»

Este movimiento defensivo también tiene una vertiente ofensiva. Esta nueva herramienta llega para preparar el terreno al inminente lanzamiento del modo adulto de ChatGPT, que permitirá crear y consumir contenido etiquetado como NSFW (No Safe For Work). OpenAI necesita un sistema de filtrado robusto antes de abrir esa compuerta.

La duda ahora es si este sistema será efectivo o si, como ocurrió en Roblox, los usuarios menores encontrarán rápidamente formas de eludir las señales que el algoritmo identifica para saltarse el bloqueo.

La opinión final del Gurú

Técnicamente y éticamente, estamos ante un campo de minas. Proteger a los menores es absolutamente prioritario, y OpenAI llega tarde a esta fiesta tras varios escándalos. Sin embargo, la implementación es tosca e invasiva. Utilizar IA para «adivinar» la edad basándose en el comportamiento es un juego peligroso que genera falsos positivos. Y obligar a un adulto inocente a enviar un selfie a una empresa externa para corregir el error de la máquina es una fricción enorme en términos de privacidad.

Es el clásico enfoque de «matar moscas a cañonazos», y me temo que la resistencia de los usuarios va a ser notable. ¡Te leemos en los comentarios! Y no te olvides de seguir a Gurú Tecno en YouTube, Instagram y Facebook.