El medio de tecnología 9to5Mac ha publicado una entrada de blog en la que informa que Apple propuso el modelo de difusión FS-DFM (Few-Step Discrete Flow-Matching), que solo requiere 8 rondas de iteraciones rápidas para generar texto con una calidad comparable a miles de rondas de iteraciones de modelos tradicionales. Esto significa que la velocidad de escritura se puede aumentar hasta 128 veces en comparación con modelos similares.

Los equipos de investigación de Apple y la Universidad Estatal de Ohio publicaron recientemente de forma conjunta un artículo que propone este nuevo modelo de lenguaje. Este modelo se centra en resolver el cuello de botella de la eficiencia en la generación de textos largos. Puede generar textos largos de alta calidad con tan solo ocho rondas de refinamiento rápido. Su efecto es comparable al de los modelos de difusión tradicionales que realizan miles de iteraciones.

Antes de profundizar en FS-DFM, es importante distinguir entre dos paradigmas de modelos de lenguaje principales:

- Los modelos autorregresivos, como ChatGPT, funcionan generando texto en serie, token por token, donde la generación de cada palabra subsiguiente depende de todas las anteriores.

- El modelo de difusión utiliza una estrategia paralela para generar múltiples palabras a la vez y luego optimiza gradualmente a través de múltiples rondas de iteración hasta que se forma una respuesta completa.

Como variante del modelo de difusión, FS-DFM simplifica aún más el proceso iterativo, buscando generar directamente el resultado final con el mínimo número de pasos. Según una entrada de blog, los investigadores de Apple idearon un sofisticado enfoque de tres pasos para lograr este avance:

- En primer lugar, el modelo está especialmente entrenado para adaptarse de forma flexible a diferentes números de iteraciones de refinamiento.

- En segundo lugar, el equipo introdujo un modelo «profesor» para brindar orientación, garantizando que el modelo pueda actualizarse de manera significativa y precisa en cada ronda de iteración, evitando al mismo tiempo el problema de la «sobrecorrección».

- Finalmente, optimizaron el propio mecanismo de iteración, permitiendo que el modelo genere el texto final en menos pasos y más robustos.

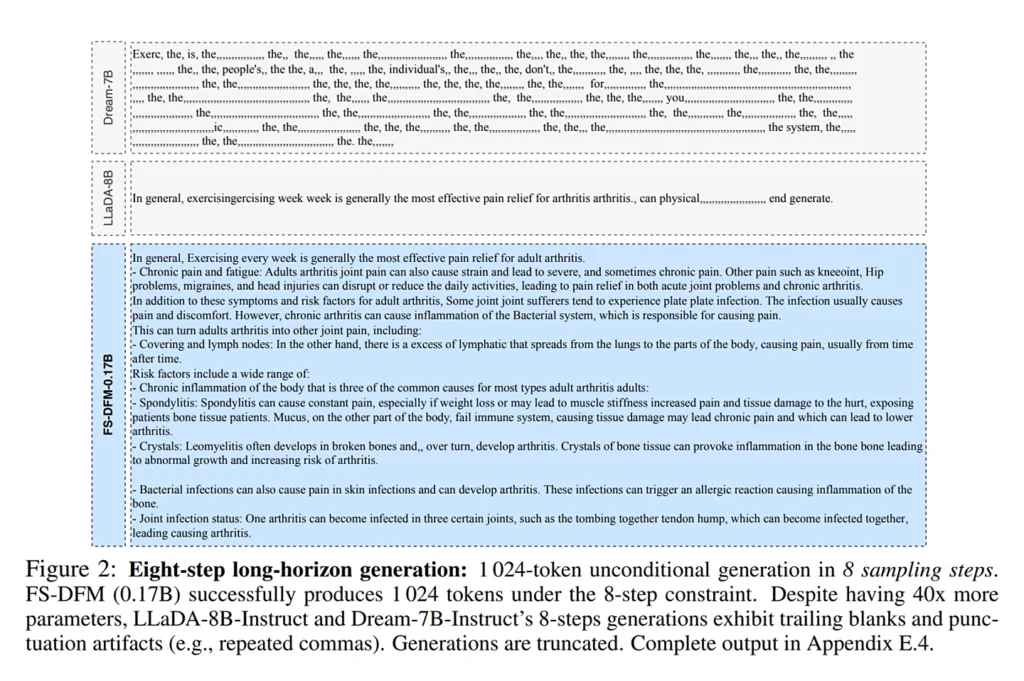

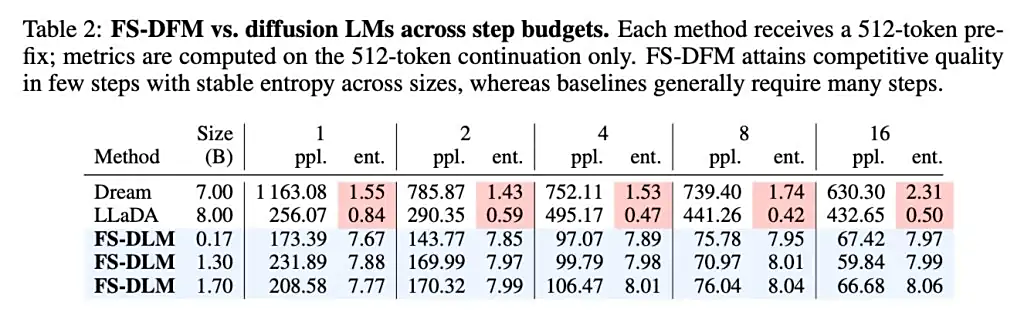

En su evaluación de rendimiento, FS-DFM también permitió comparaciones con el modelo Dream, de 7 mil millones de parámetros, y el modelo LLaDA, de 8 mil millones de parámetros. Los resultados de las pruebas mostraron que incluso las variantes de FS-DFM, con tan solo entre 170 y 1700 millones de parámetros, mostraron menor perplejidad y una entropía más estable en dos métricas clave: perplejidad (una medida de la precisión y fluidez del texto; cuanto menor, mejor) y entropía (una medida de la confianza en la selección de palabras del modelo. Una entropía demasiado baja puede provocar una repetición monótona; una entropía demasiado alta puede generar incoherencias).

El veredicto del Gurú: FS-DFM de Apple: Un salto de eficiencia en la generación de texto que podría democratizar la IA

El nuevo modelo Few-Step Discrete Flow-Matching (FS-DFM) propuesto por Apple y la Universidad Estatal de Ohio representa un avance significativo en la eficiencia de la generación de texto mediante inteligencia artificial. La capacidad de acelerar la escritura de textos largos hasta 128 veces, mientras mantiene una calidad comparable a la de modelos tradicionales que requieren miles de iteraciones, es un hito impresionante.

Este modelo aborda uno de los mayores desafíos en la IA generativa: la eficiencia computacional, especialmente para la generación de textos extensos. Mientras que modelos autorregresivos como ChatGPT generan texto secuencialmente (token por token), los modelos de difusión trabajan en paralelo. FS-DFM, al optimizar drásticamente el proceso iterativo de la difusión a solo ocho pasos, no solo reduce el tiempo de generación, sino que también minimiza los recursos computacionales necesarios.

El enfoque de tres pasos empleado por los investigadores de Apple es ingenioso:

- Entrenamiento flexible: Permite que el modelo se adapte a diferentes números de iteraciones, lo que le otorga versatilidad.

- Modelo «profesor»: Esta guía asegura que cada iteración sea significativa y precisa, evitando la «sobrecorrección», un problema común en los procesos iterativos.

- Mecanismo de iteración optimizado: Fundamental para lograr la robustez y la velocidad en la generación final del texto.

Lo más notable es que FS-DFM logra estos resultados con muchos menos parámetros (entre 170 y 1700 millones) en comparación con modelos de la competencia como Dream (7 mil millones) o LLaDA (8 mil millones), demostrando una mayor eficiencia en el uso de recursos. Su menor perplejidad y entropía más estable son indicadores clave de la coherencia y naturalidad del texto generado.

Este avance podría tener implicaciones profundas. Una generación de texto de alta calidad a una velocidad y con una eficiencia computacional tan elevadas podría democratizar aún más el acceso a la IA generativa, permitiendo su implementación en dispositivos con recursos más limitados o reduciendo drásticamente los costos operativos en la nube. Además, podría acelerar el desarrollo de aplicaciones que requieran respuestas textuales rápidas y extensas, desde resúmenes de documentos hasta la creación de contenido creativo.

Apple, con FS-DFM, está demostrando que su investigación en IA es de vanguardia, buscando no solo la inteligencia, sino también la eficiencia y la practicidad en el uso de estos modelos.

¿Qué opinas del modelo FS-DFM de Apple y su capacidad para acelerar la generación de texto? ¿Creéis que esta eficiencia es el futuro de la IA generativa? El debate está servido. Déjanos tu opinión en los comentarios y únete a la discusión en Instagram, Facebook y YouTube.